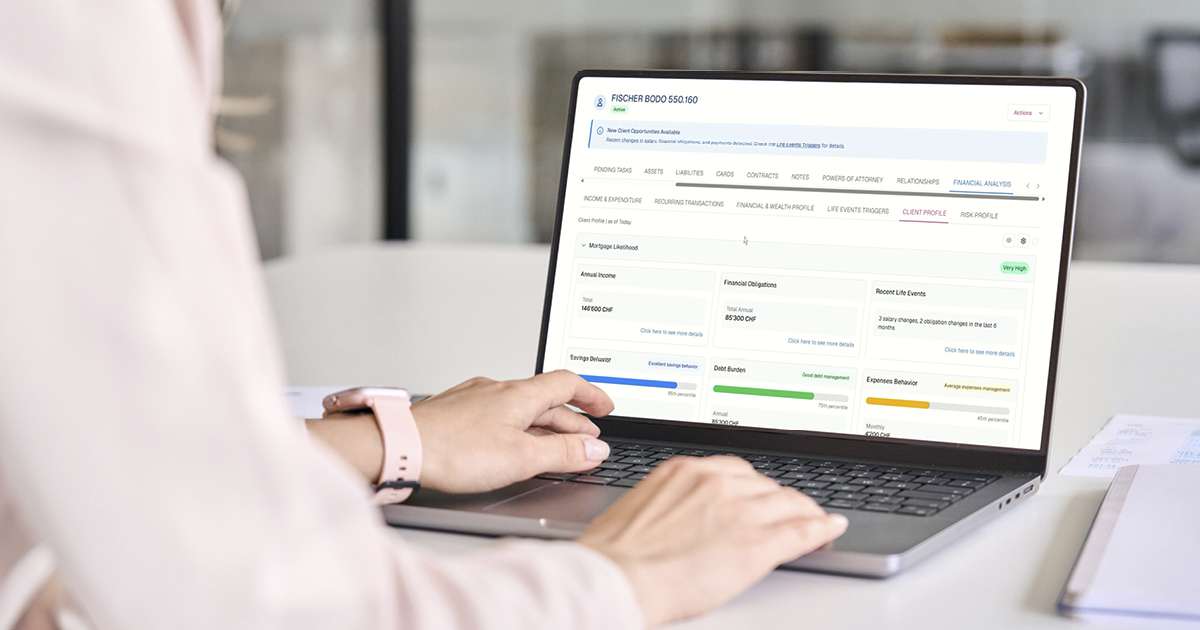

Technologisch gesehen kombiniert der Ansatz von Contovista zwei Ebenen. Die erste Ebene umfasst robuste, spezialisierte Systeme für die Kategorisierung von Transaktionsdaten und ihre Analyse durch traditionelles Machine Learning (ML). Dafür haben wir unsere Enrichment Engine für die Datenkategorisierung und unsere Client Analytics für die Auswertung entwickelt. Dieser Ansatz ist ökonomisch, effizient und hoch präzise und kundenzentriert, denn die Analysen liefern handlungsrelevante Insights zur Finanzsituation (etwa Gehaltsentwicklung, neue finanzielle Verpflichtungen, Churn-Signale. Immobilienfinanzierung, Risikoprofil).

Auf der zweiten Ebene nutzen wir dann GenAI, um die Insights zu operationalisieren. Mit schlanken, effizienten LLMs bauen wir produktive Workflows rund um die Transaktionsdaten: effiziente Schnittstellen, Automatisierungen und Entscheidungsunterstützung etwa für die Kundenberatung oder das Cross-Selling.

Überlegener ROI – mit AI-Lösungen von Contovista

Die Lösungen von Contovista kombinieren also Domänen-spezifische Analytics auf ML-Basis mit den Vorteilen von GenAI. Die Strategie lautet somit: Differenzierung statt grenzenloser Skalierung und der damit verbundenen Kosten – oder anders gesagt, Skalierung nur da, wo sie Sinn macht. Aus Sicht der Finanzinstitute steht damit ein wirksamer Transformationshebel bereit, dessen ROI die kostspieligen Mega-Initiativen der grossen Player in vielen Fällen übertreffen dürfte.

Willst du mehr darüber erfahren, wie Schweizer Banken mit der richtigen Strategie die Risiken des AI-Hypes umschiffen und eine fokussierte Transformation umsetzen? Dann wende dich einfach an unsere Expert:innen.